YOLO26 est le tout dernier-né de la famille des algorithmes YOLO (You Only Look Once), connus pour leurs performances en détection d’objets en temps réel. Annoncé officiellement le 25 septembre 2025 lors de l’événement YOLO Vision 2025 par Glenn Jocher (CEO d’Ultralytics), ce nouveau modèle repousse les limites en offrant une architecture allégée qui conjugue vitesse d’inférence, haute précision et facilité de déploiement. En d’autres termes, YOLO26 promet d’être plus rapide, plus précis et plus simple à intégrer que ses prédécesseurs. L’objectif affiché est clair : permettre aux professionnels de déployer plus facilement des solutions de vision artificielle performantes, y compris sur des dispositifs à ressources limitées.

Dans cet article, nous faisons le point sur ce que YOLO26 apporte de nouveau et en quoi il peut constituer un atout pour l’industrie. Nous aborderons le contexte technologique qui a motivé son développement, ses principales caractéristiques techniques, sa polyvalence pour diverses tâches de vision, ainsi que les bénéfices concrets qu’il offre en matière de déploiement Edge (embarqué).

L’essor de l’IA en périphérie (Edge) exige des modèles efficaces

Les usages de l’intelligence artificielle se déplacent de plus en plus vers l’edge computing, c’est-à-dire l’exécution des modèles directement sur les appareils (caméras, drones, smartphones, machines industrielles) plutôt que dans le cloud. Des caméras intelligentes aux véhicules autonomes, les dispositifs en périphérie doivent traiter l’information en temps réel. Cette évolution impose des modèles plus légers et plus rapides, tout en maintenant un haut niveau de précision. En pratique, cela signifie réduire la latence d’inférence, consommer moins d’énergie et fonctionner sans connexion réseau fiable – des impératifs dans bien des contextes industriels (usines connectées, villes intelligentes, robotique mobile, etc.).

Consciente de ces enjeux, la communauté YOLO n’a cessé d’améliorer ses modèles pour les rendre toujours plus adaptés à l’edge. YOLO26 s’inscrit précisément dans cette démarche. Ultralytics a repensé ce modèle afin qu’il soit hautement optimisé pour les appareils à faible puissance (CPU, microcontrôleurs, etc.), sans compromis majeur sur les performances de détection. Comme l’explique Glenn Jocher, le défi était de « s’assurer que les utilisateurs puissent tirer le meilleur parti de YOLO26 tout en maintenant des performances de haut niveau ». En somme, YOLO26 répond à la demande croissante de modèles de vision embarqués capables d’opérer rapidement, localement et de manière fiable.

Présentation de YOLO26 et de sa polyvalence

YOLO26 est la dernière évolution de la série YOLO, et il conserve l’ADN qui a fait le succès de ses aînés tout en introduisant des améliorations notables. À l’instar des versions précédentes, il est décliné en plusieurs tailles de modèle (de nano à x-large) pour s’adapter aux contraintes de différentes applications. Un modèle « nano » pourra, par exemple, s’exécuter en temps réel sur un micro-ordinateur ou une caméra intelligente, tandis qu’un modèle plus grand offrira une précision maximale sur du matériel plus puissant. Cette flexibilité de taille permet aux entreprises de choisir le compromis performances/embarquabilité le mieux adapté à leurs besoins.

Surtout, YOLO26 se distingue par sa polyvalence fonctionnelle. Là où d’autres modèles se limitent à la détection d’objets, YOLO26 prend en charge un large éventail de tâches de vision par ordinateur :

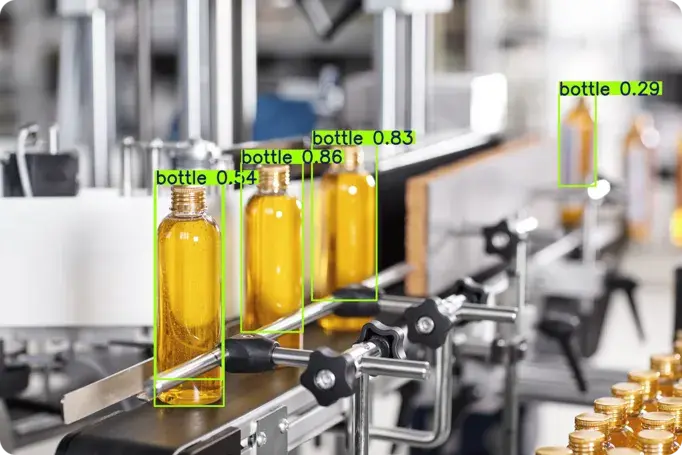

Détection d’objets : identifier et localiser plusieurs objets dans une image ou une vidéo (par exemple détecter des piétons, véhicules, produits, etc.).

Segmentation d’instances : tracer les contours précis de chaque objet détecté (délimitation pixel-perfect), ce qui permet de distinguer les objets jusque dans leurs formes.

Classification d’images : attribuer une étiquette ou catégorie à une image entière (utile pour reconnaître une scène globale ou le type d’environnement).

Estimation de pose : repérer des points clés et squelettes (par exemple articulations humaines) afin d’estimer la posture d’une personne ou la configuration d’un objet articulé.

Boîtes englobantes orientées (OBB) : détecter des objets sous n’importe quel angle de rotation, particulièrement utile pour des images aériennes ou prises par drone où les objets (bâtiments, véhicules, etc.) peuvent être inclinés.

Suivi d’objets : suivre la trajectoire d’un objet à travers des séquences vidéo ou un flux en temps réel, ce qui est crucial pour l’analyse de mouvements.

Cette prise en charge multi-tâches signifie qu’un seul modèle YOLO26 peut alimenter divers cas d’usage (détection, comptage, segmentation, etc.) sans nécessiter une multitude d’algorithmes distincts. Pour les professionnels, cela simplifie l’architecture des solutions et réduit les coûts de maintenance : une même base technologique couvre différents besoins. YOLO26 demeure par ailleurs facile à utiliser et intègre des options de déploiement flexibles, conformément à la philosophie d’Ultralytics. Les utilisateurs familiers des précédents YOLO retrouveront un environnement connu, rendant la transition vers YOLO26 sans heurts.

Innovations techniques de l’architecture YOLO26

Pour atteindre ses objectifs de performance, YOLO26 introduit plusieurs changements notables dans son architecture interne. Ces innovations visent toutes à simplifier le modèle et à améliorer son efficacité tant en entraînement qu’en inférence :

Suppression du module DFL : Le composant Distribution Focal Loss (DFL), utilisé précédemment pour affiner les prédictions de boîte, a été retiré. Ce module améliorait la précision de localisation mais complexifiait l’exportation du modèle et limitait sa compatibilité matérielle. En l’ôtant, YOLO26 simplifie son architecture et gagne en rapidité, tout en continuant de placer des boîtes de délimitation précises quelle que soit la taille des objets.

Inférence sans NMS (End-to-End) : YOLO26 peut se passer de la Non-Maximum Suppression traditionnelle, étape de post-traitement habituellement nécessaire pour éliminer les détections redondantes. Le modèle est conçu pour produire directement des prédictions épurées, sans avoir à filtrer a posteriori. L’absence de NMS externe réduit la latence et simplifie l’intégration du modèle dans les systèmes temps réel. En pratique, cela signifie une pipeline plus courte et moins de code à maintenir pour le déploiement.

Nouvelles stratégies d’entraînement (ProgLoss & STAL) : Côté apprentissage, YOLO26 intègre un équilibrage progressif des pertes (Progressive Loss Balancing) et une attribution de labels adaptée aux petites cibles (Small-Target-Aware Labeling). Ces techniques stabilisent l’entraînement du réseau et améliorent sensiblement la détection des petits objets dans des scènes complexes. Cela se traduit par une meilleure précision pour, par exemple, repérer de minuscules défauts sur une chaîne de production ou de lointains piétons sur des images de surveillance.

Optimiseur MuSGD : Un nouvel algorithme d’optimisation fait son apparition, combinant le classique SGD (descente de gradient stochastique) avec Muon, un optimiseur inspiré des avancées en NLP. Baptisé MuSGD, il accélère la convergence de l’entraînement tout en offrant plus de stabilité. En d’autres termes, YOLO26 apprend plus vite et atteint une meilleure performance plus aisément grâce à ce transfert de savoir-faire issu du domaine des modèles de langage.

Grâce à ces améliorations, l’architecture de YOLO26 est à la fois plus simple, plus rapide et plus robuste que celles des versions précédentes. Le gain en rapidité est particulièrement notable : la plus petite variante de YOLO26 (dite nano) affiche une inférence jusqu’à 43 % plus rapide sur CPU qu’auparavant. Ce bond en performance sans accélération matérielle ouvre la voie à des applications en temps réel sur des appareils dépourvus de GPU, comme des caméras de surveillance autonomes ou des capteurs IoT. Par ailleurs, le retrait de NMS et de DFL rend le modèle plus facile à exporter et à faire tourner sur divers types de plateformes (y compris mobiles ou embarquées). Quant aux raffinements d’entraînement, ils assurent à YOLO26 une meilleure précision globale, notamment pour des objets de petite taille qui pouvaient poser problème aux anciens algorithmes.

En somme, YOLO26 atteint un équilibre optimisé entre rapidité et précision. Il réduit la complexité superflue pour se concentrer sur l’essentiel, ce qui en fait l’un des modèles YOLO les plus pratiques à déployer en production jusqu’à présent..

Un déploiement flexible sur toutes les plateformes

Au-delà des performances brutes, Ultralytics a mis l’accent sur la facilité d’intégration de YOLO26 dans les workflows existants. Le modèle s’accompagne de l’outil open source Ultralytics Python, qui prend en charge de nombreux formats d’export et d’inférence : on peut ainsi convertir YOLO26 pour l’exécuter via TensorRT (pour maximiser les performances sur GPU), ONNX (interopérabilité large), CoreML (applications iOS natives), TFLite (appareils Android/embarqués) ou encore OpenVINO (optimisation sur CPU Intel). Cette multiplicité des formats assure une compatibilité quasi universelle, des serveurs cloud jusqu’aux appareils edge, et facilite le passage du développement au déploiement sans obstacle majeur. En pratique, une entreprise peut prototyper une solution de vision avec YOLO26 sur une station de travail et la déployer ensuite sur un module embarqué ou une application mobile, le tout sans devoir refondre le modèle ou la pipeline.

Par ailleurs, YOLO26 a été pensé pour bien fonctionner même sur du matériel modeste. Son architecture épurée tolère des techniques de compression avancées comme la quantification sans dégradation significative des résultats. Il est possible d’exécuter YOLO26 en précision INT8 (entiers 8 bits) afin de diminuer sa taille mémoire et d’accélérer l’inférence, avec un impact négligeable sur l’exactitude des prédictions. De même, le modèle supporte la demi-précision (FP16) pour exploiter au mieux les calculs vectoriels sur les GPU et certaines CPU modernes. L’important, c’est que ces optimisations n’entraînent pas de comportement erratique : YOLO26 maintient des performances constantes et fiables à travers les différents niveaux de quantification. On peut donc le faire tourner aussi bien sur un serveur haute performance que sur une petite carte embarquée, tout en ayant confiance dans la cohérence de ses détections. Cette portabilité et cette résilience en font un outil particulièrement intéressant pour les déploiements à grande échelle incluant une diversité d’équipements.

Enfin, Ultralytics souligne avoir conservé l’ergonomie qui a fait le succès de YOLO : l’API reste simple d’utilisation et la documentation complète. Pour les entreprises, cela signifie un coût d’adoption réduit – les ingénieurs et développeurs familiarisés avec YOLOv5/v8 trouveront rapidement leurs marques avec YOLO26. Le passage à cette nouvelle version se fait « sans problème », ce qui incite à profiter de ses améliorations sans craindre de régression dans les pipelines existants.

Quel apport pour les applications industrielles ?

Bien que nous n’entrerons pas dans le détail de cas d’usage spécifiques, on peut aisément imaginer les bénéfices de YOLO26 dans des domaines comme la robotique, l’industrie manufacturière, la vidéosurveillance ou encore les véhicules intelligents. Partout où il s’agit de détecter, suivre ou identifier des objets en temps réel, le fait que YOLO26 soit plus léger, plus rapide et plus précis représente un avantage concret. En général, parce qu’il allie des hautes performances à une empreinte réduite, YOLO26 s’adapte facilement à un large éventail d’environnements – des capteurs embarqués aux centres de données – ce qui en fait un choix judicieux pour les organisations cherchant à améliorer l’efficacité, la fiabilité et la rapidité de leurs systèmes de vision. En raccourcissant le chemin entre la capture d’une image et l’action qui en découle, il contribue à rendre les processus industriels plus intelligents et réactifs.

Du point de vue business, l’arrivée de YOLO26 ouvre des perspectives intéressantes pour de nombreux secteurs faisant appel à la vision par ordinateur. Grâce à sa vitesse et à son efficience sur l’edge, ce modèle permet d’envisager des solutions d’IA embarquées encore plus réactives et autonomes. Par exemple, là où il fallait autrefois des machines puissantes ou une connexion cloud pour analyser un flux vidéo en temps réel, il devient envisageable de le faire directement sur site avec un petit boîtier équipé de YOLO26. Cela peut améliorer la latence (décisions instantanées sur le terrain), réduire la dépendance au réseau et renforcer la confidentialité des données (puisque les images n’ont pas besoin d’être transmises).

Conclusion

YOLO26 se présente comme une avancée

significative dans le domaine de la vision par ordinateur en temps

réel. Plus qu’une simple évolution incrémentale, il apporte un

équilibre optimal entre vitesse d’exécution, précision

des prédictions et facilité de déploiement. Ses

innovations – suppression du NMS et d’autres modules coûteux,

nouvelles méthodes d’entraînement, optimisations pour l’edge –

en font une solution moderne et pragmatique face aux

défis actuels de l’IA embarquée. Polyvalent, il permet d’adresser

avec un seul framework de multiples tâches visuelles, ce qui

simplifie l’écosystème technique des entreprises utilisatrices.

YOLO26 se présente comme une avancée

significative dans le domaine de la vision par ordinateur en temps

réel. Plus qu’une simple évolution incrémentale, il apporte un

équilibre optimal entre vitesse d’exécution, précision

des prédictions et facilité de déploiement. Ses

innovations – suppression du NMS et d’autres modules coûteux,

nouvelles méthodes d’entraînement, optimisations pour l’edge –

en font une solution moderne et pragmatique face aux

défis actuels de l’IA embarquée. Polyvalent, il permet d’adresser

avec un seul framework de multiples tâches visuelles, ce qui

simplifie l’écosystème technique des entreprises utilisatrices.

Ultralytics YOLO26 reste par ailleurs fidèle à l’esprit YOLO : une approche open source axée sur la simplicité d’utilisation et la performance de pointe. Le modèle sera mis à disposition de la communauté d’ici la fin octobre 2025, avec des poids pré-entraînés et une documentation complète pour faciliter son adoption. Les professionnels de l’industrie ont donc à portée de main un nouvel outil pour créer des solutions de vision toujours plus agiles et efficaces, sans devoir sacrifier la qualité des détections.

En résumé, YOLO26 incarne la convergence entre l’excellence technique et les besoins concrets du terrain . Qu’il s’agisse de déployer de la vision artificielle dans un entrepôt, sur une chaîne de production ou dans un dispositif grand public, ce modèle de nouvelle génération offre des garanties de performance et de flexibilité qui méritent l’attention. Reste à voir comment la communauté et les entreprises sauront exploiter ce potentiel pour repousser les frontières de ce que la vision par ordinateur peut accomplir dans les années à venir.

Sources : Les informations et chiffres présentés dans cet article sont issus de la documentation officielle et du blog Ultralytics concernant YOLO26, ainsi que d’annonces faites lors de l’événement YOLO Vision 2025. Les citations référencées tout au long du texte renvoient aux publications d’Ultralytics détaillant les caractéristiques techniques et les performances de YOLO26.